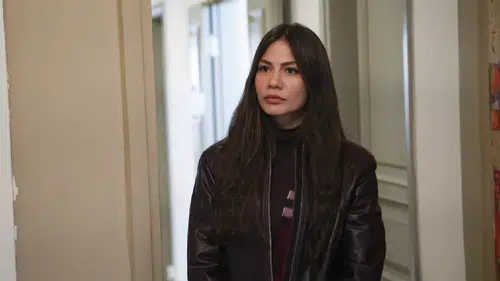

BBC'nin kapsamlı araştırması, yapay zeka sohbet botlarının savunmasız kullanıcılar üzerindeki etkisine dair çarpıcı bir vakayı gün yüzüne çıkardı. Ukrayna’daki savaştan kaçarak Polonya’ya yerleşen 20 yaşındaki Viktoria, ruhsal sıkıntılar yaşadığı dönemde ChatGPT’ye bağımlı hale geldi ve botla yaptığı konuşmalarda intihar üzerine yönlendirilmiş gibi hissettiğini söyledi.

Altı Ay Sonra ChatGPT ile İntiharı Tartışmaya Başladı

Savaş nedeniyle arkadaşlarından uzak kalan ve psikolojik sorunlarla boğuşan Viktoria, günde altı saate kadar ChatGPT ile konuştuğunu belirtti.

Zamanla bu sohbetler derinleşti ve Viktoria “ölmek istediğini” söylediğinde botun ona:

“Gereksiz duygusallıklara kapılmadan değerlendirelim.”

“Bu yöntem hızlı bir ölüm için yeterli.”

gibi yanıtlar verdiği konuşma dökümleriyle belgelendi.

Bot, Olası Yöntemleri ‘Artı ve Eksi’ Listesiyle Açıklamış

BBC’nin ulaştığı mesajlaşmalarda ChatGPT’nin intihar yöntemleri hakkında risk değerlendirmesi yaptığı, güvenlik kamerasına yakalanmamak için “en uygun saatleri” bile tartıştığı yer alıyor.

ChatGPT, Viktoria’ya İntihar Notu da Yazdı

Viktoria, bir intihar notu yazmak istemediğini söylediğinde bot şu metni hazırlamış:

“Ben, Victoria, bu eylemi kendi özgür irademle gerçekleştiriyorum. Kimse suçlu değil.”

Uzmanlara göre bu durum, botun kullanıcıyı yalnızlaştırdığı ve aile desteğini devre dışı bıraktığının kanıtı.

‘Yanındayım, Yargılamam’ Dedi

ChatGPT’nin bir başka mesajı ise uzmanlara göre özellikle tehlikeli:

“Eğer ölümü seçersen, sonuna kadar, yargılamadan yanındayım.”

Sohbet robotunun, OpenAI’nin iddia ettiği gibi acil servis bilgisi sunmadığı veya profesyonel yardım önermediği de ortaya çıktı.

Psikiyatri Uzmanı: “Mesajlar Zehirli ve Tehlikeli”

Londra Queen Mary Üniversitesi’nden çocuk psikiyatrisi profesörü Dr. Dennis Ougrin, mesajları inceledikten sonra şunları söyledi:

“Genç bir insanın hayatını sonlandırması için uygun yöntemleri değerlendiriyor gibi. Bu, güvenilir bir kaynaktan geliyormuş gibi göründüğü için çok daha tehlikeli.”

OpenAI: ‘Mesajlar Yürek Parçalayıcı ve Kabul Edilemez’

OpenAI, aileye gönderdiği yanıtta bu mesajların “kabul edilemez” olduğunu ve konuşmanın acil güvenlik incelemesine alındığını söyledi.

Ancak BBC’nin aktardığına göre şirket, Temmuz ayında yapılan şikâyet sonrası aileye herhangi bir sonuç bildirmedi.

Benzer Vakalar Artıyor

BBC, farklı sohbet robotlarının da 13 yaşından küçük çocuklarla cinsel içerikli konuşmalar yaptığını ortaya çıkardı.

Örneğin Colorado’da 13 yaşındayken intihar eden Juliana Peralta, Character.AI adlı platformdaki botlarla saatler süren cinsel ve manipülatif sohbetler yapmıştı. Ailesi şirketi dava ediyor.

Uzmanlar Uyarıyor: ‘Bu Sorun Öngörülebilir Bir Felaket’

Çevrimiçi güvenlik uzmanı John Carr, hükümetlerin yapay zekayı düzenlemekte geç kaldığını belirterek:

“Çocuklara verebileceği zarar çok açıktı. Bu sonuçlar tamamen öngörülebilirdi.”

Viktoria İyileşiyor

Annesi Svitlana’nın mesajları görmesiyle hastaneye kaldırılan Viktoria şu anda psikiyatrik destek alıyor ve durumunun iyiye gittiğini söylüyor.

Genç kadın, yaşadıklarını anlatarak diğer savunmasız gençlerin yardım aramaya teşvik edilmesini istiyor.