Yapay zeka destekli deepfake teknolojileri 2025 yılı itibarıyla büyük bir sıçrama yaptı. Siyasilerden ünlülere, şirket yöneticilerinden sıradan vatandaşlara kadar geniş bir kitleyi hedef alan sahte video, ses ve dijital kimlik üretimi son iki yılda yaklaşık yüzde 900 oranında arttı. Ancak uzmanlara göre asıl kırılma noktası henüz yaşanmadı.

ABD’de Buffalo Üniversitesi’nden bilgisayar bilimci Siwei Lyu’nun liderliğinde yürütülen ve The Conversation’da yayımlanan araştırmaya göre, 2026 yılında deepfake’ler çok daha tehlikeli bir boyuta ulaşabilir. Çalışmada, bugüne kadar görülen sahte içeriklerin büyük bölümünün “önceden hazırlanmış” olduğu, bir sonraki aşamada ise insanlarla canlı şekilde etkileşime girebilen sentetik kimliklerin yaygınlaşacağı vurgulandı.

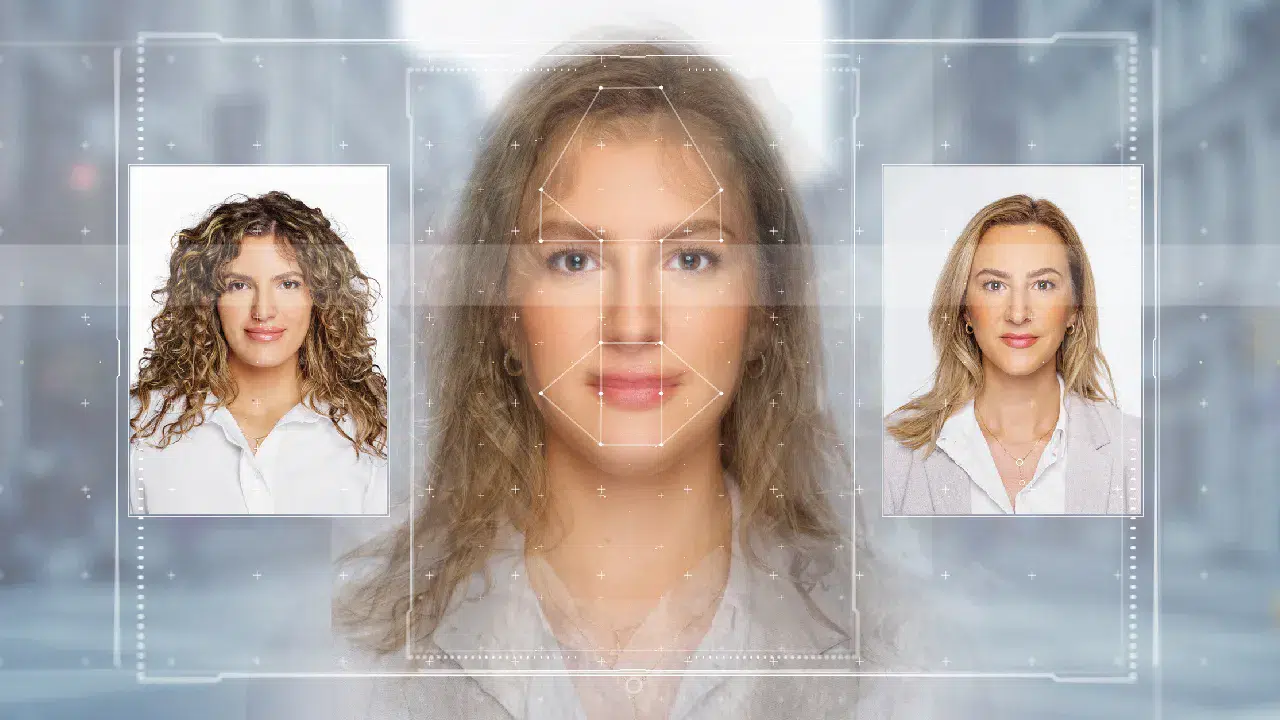

Kalite insan gözünü geçti

Araştırmaya göre internetteki deepfake sayısı 2023’te yaklaşık 500 bin seviyesindeyken, 2025’te 8 milyona ulaştı. Ancak uzmanlar asıl sorunun sayıdan çok kalite olduğuna dikkat çekiyor. Yeni nesil yapay zeka modelleri, yüz ifadeleri, mimikler ve baş-hareketleri arasında “zamansal tutarlılık” sağlayarak eski deepfake’lerde görülen titreme ve bozulmaları büyük ölçüde ortadan kaldırdı. Bu da sahte içeriklerin sıradan kullanıcılar tarafından ayırt edilmesini neredeyse imkânsız hale getirdi.

Ses klonlama dolandırıcılığın merkezinde

Çalışmada, ses klonlama teknolojisinin de kritik bir eşiği geçtiği belirtildi. Artık yalnızca birkaç saniyelik bir ses kaydıyla, doğal vurguya ve duyguya sahip birebir kopyalar üretilebiliyor. Bazı büyük perakende şirketlerinin günde binin üzerinde yapay zeka kaynaklı dolandırıcılık araması aldığı ifade edilirken, sentetik sesleri ele veren klasik işitsel ipuçlarının da büyük ölçüde ortadan kalktığı aktarıldı.

Herkes deepfake üretebiliyor

Deepfake üretimi artık ileri düzey teknik bilgi gerektirmiyor. Basit bir metin girdisi ve kısa bir işlem süresiyle yüksek kaliteli sahte videolar hazırlanabiliyor. Uzmanlar bu durumu deepfake’lerin “demokratikleşmesi” olarak tanımlarken, aynı zamanda kötüye kullanımın da kitlesel hale geldiği uyarısında bulunuyor.

Asıl kırılma: gerçek zamanlı deepfake’ler

Siwei Lyu’ya göre 2026’nın en büyük riski, önceden hazırlanmış sahte videolar değil. Asıl tehlike; görüntülü aramalara katılabilen, karşısındaki kişiye anında yanıt verebilen, yüz ifadesini, ses tonunu ve beden dilini bağlama göre uyarlayan gerçek zamanlı yapay kimlikler olacak.

Bu aşamada sorun, “Bu kişi X’e benziyor mu?” sorusundan çıkıp, “Bu kişi zaman içinde X gibi davranıyor mu?” noktasına taşınıyor. Uzmanlara göre dolandırıcıların sabit videolar yerine canlı tepki verebilen avatarlar kullanması, deepfake’lerin hem tespit edilmesini hem de engellenmesini çok daha zor hale getirecek.